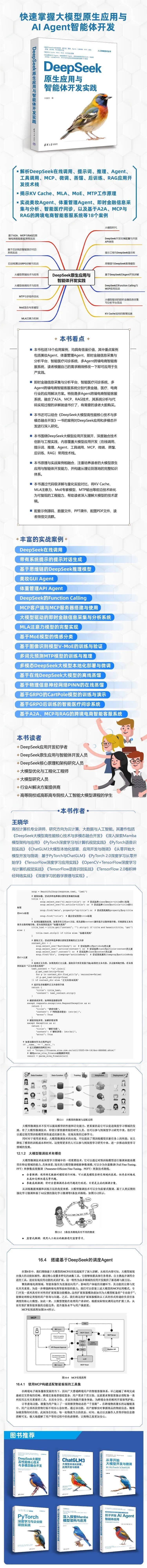

《DeepSeek原生应用与智能体开发实践》

本书内容

《DeepSeek原生应用与智能体开发实践》围绕DeepSeek大模型应用开发展开,深度融合技术创新与工程实践,内容覆盖大模型应用开发(在线调用、提示词、推理、Agent、工具调用、MCP、微调、蒸馏、后训练、RAG)技术栈及其案例。书中原理与案例相融合,注重培养读者的大模型原生应用与智能体开发能力,并构建从理论到落地的完整知识体系。《DeepSeek原生应用与智能体开发实践》配套示例源码、PPT课件、配图PDF文件、读者微信交流群。

本书作者

本书读者

《DeepSeek原生应用与智能体开发实践》既适合DeepSeek开发初学者、大模型原生应用与智能体开发人员、模型优化与工程化工程师、大模型研究人员、行业AI解决方案提供商,也适合高等院校及高职高专院校学习人工智能大模型的学生。

本书目录

目 录

第 1 章 大模型时代1

1.1 大模型的诞生与发展1

1.1.1 大语言模型发展简史与概念2

1.1.2 大语言模型的生成策略3

1.2 大语言模型发展的里程碑4

1.2.1 注意力机制是大模型发展的里程碑4

1.2.2 注意力机制的关键创新5

1.2.3 注意力机制对语言建模的影响7

1.2.4 大模型中的涌现与Scaling Law10

1.2.5 大模型的训练方法SFT与RLHF12

1.3 大语言模型发展的“DeepSeek时刻”13

1.3.1 重塑世界AI格局的DeepSeek-V314

1.3.2 推理能力大飞跃的DeepSeek-R116

1.4 大模型的应用与展望18

1.4.1 大模型的实际应用18

1.4.2 大模型发展面临的展望19

1.5 本章小结20

第 2 章 DeepSeek开发环境配置与开放API使用21

2.1 安装Python开发环境21

2.1.1 Miniconda的下载与安装21

2.1.2 PyCharm的下载与安装24

2.2 安装DeepSeek开发框架28

2.2.1 不同显卡与运行库的选择28

2.2.2 PyTorch GPU版本的安装28

2.2.3 测试PyTorch和CUDA安装信息30

2.3 在线DeepSeek应用配置详解31

2.3.1 DeepSeek简介与免费使用32

2.3.2 带有特定格式的DeepSeek在线调用33

2.3.3 带有约束的DeepSeek在线调用35

2.3.4 将DeepSeek与PyCharm相连37

2.4 本章小结39

第 3 章 提示工程与DeepSeek提示库40

3.1 提示工程Prompt详解40

3.1.1 什么是提示工程41

3.1.2 提示工程的关键要素与DeepSeek配置41

3.1.3 DeepSeek提示工程化写作技巧与示例43

3.1.4 系统、上下文和角色提示的进阶应用44

3.2 DeepSeek中的提示库46

3.2.1 DeepSeek中提示库介绍与基本使用46

3.2.2 带有系统提示的提示对话生成50

3.3 本章小结51

第 4 章 思维链与DeepSeek推理模型52

4.1 思维链详解52

4.1.1 思维链应用场景53

4.1.2 思维链的定义与分类54

4.2 基于思维链的DeepSeek推理模型实战55

4.2.1 通过Prompt提示构建思维链56

4.2.2 DeepSeek-Reasoner推理模型实战58

4.3 本章小结60

第 5 章 基于DeepSeek的Agent开发详解61

5.1 Agent开发概述62

5.1.1 Agent的定义与核心机制62

5.1.2 API Agent与GUI Agent63

5.2 基于DeepSeek的美妆GUI Agent实践65

5.2.1 GUI Agent库的安装与使用66

5.2.2 使用DeepSeek自动化获取网页端天气信息68

5.2.3 根据天气信息给出美妆建议70

5.3 基于DeepSeek的体重管理API Agent实践72

5.3.1 API Agent的注册与使用73

5.3.2 实现卡路里计算与运动建议的功能76

5.4 本章小结77

第 6 章 DeepSeek的Function Calling与MCP应用实战78

6.1 DeepSeek自带的Function Calling详解78

6.1.1 Python使用工具的基本原理79

6.1.2 DeepSeek工具使用详解80

6.1.3 DeepSeek工具箱的使用83

6.1.4 DeepSeek工具调用判定依据89

6.2 给大模型插上翅膀的MCP协议详解93

6.2.1 MCP协议目的、功能与架构详解94

6.2.2 MCP实战1:本地工具服务端搭建96

6.2.3 MCP实战2:本地客户端搭建与使用98

6.3 在线MCP服务器的搭建与使用实战102

6.3.1 在线MCP服务器搭建102

6.3.2 在线MCP服务的连接和使用103

6.4 本章小结105

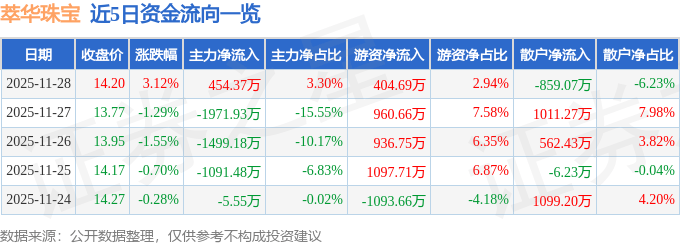

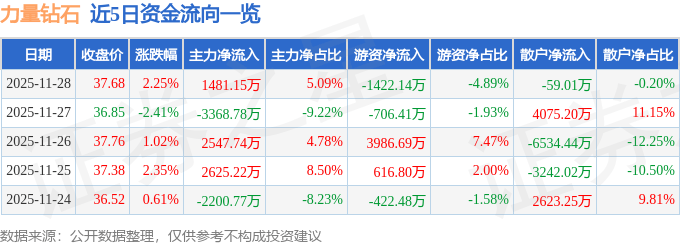

第 7 章 大模型驱动的即时金融信息采集与分析平台106

7.1 网络爬取工具Crawl4AI详解106

7.1.1 大模型传递数据的方式107

7.1.2 服务于大模型的Crawl4AI107

7.1.3 Crawl4AI的安装与基本使用108

7.2 DeepSeek驱动的即时金融信息采集与分析平台实战109

7.2.1 使用Crawl4AI爬取金融网站110

7.2.2 对链接内容进行解析111

7.2.3 使用DeepSeek抽取和分析金融信息113

7.2.4 实现DeepSeek驱动的即时金融信息采集与分析平台115

7.2.5 将DeepSeek设置不同的人设并对金融信息进行分析115

7.3 本章小结116

第 8 章 DeepSeek核心技术1: KV Cache加持的推理加速117

8.1 自回归生成模型中的资源计算117

8.1.1 自回归模型的计算量118

8.1.2 自回归模型的缓存优化118

8.2 自回归生成模型中的推理加速详解120

8.2.1 模型推理中的“贪心生成”与“采样生成”121

8.2.2 模型推理过程中的冗余计算问题解析122

8.2.3 初识模型推理中的KV Cache与代码实现124

8.3 减少空间占用的自回归模型代码实现与详解126

8.3.1 经典自回归模型详解126

8.3.2 能够减少空间占用的自回归模型代码完整实现128

8.3.3 缓存使用与传递过程详解132

8.4 减少空间占用的生成模型实战与推理资源消耗量化对比134

8.4.1 模型参数配置与训练数据的准备134

8.4.2 带有缓存的生成模型训练136

8.4.3 未运行缓存的生成模型推理资源量化展示137

8.4.4 在缓存的生成模型推理资源量化展示139

8.4.5 使用细精度修正模型输出140

8.5 本章小结140

第 9 章 DeepSeek核心技术2:MLA注意力机制141

9.1 从推理角度详解MLA注意力模型与代码实现142

9.1.1 大模型的推理过程142

9.1.2 通用大模型的显存占用量化计算143

9.1.3 手把手MLA注意力公式的总体推导145

9.2 从缓存角度详解MLA注意力模型与代码实现146

9.2.1 优化的MLA模型实现1:压缩低秩空间147

9.2.2 优化的MLA模型实现2:核心注意力矩阵计算148

9.2.3 优化的MLA模型实现3:对显存KV Cache部分的压缩149

9.2.4 带有缓存的MLA注意力模型完整实现149

9.3 MLA注意力模型的完整补充讲解152

9.3.1 调参、记忆力以及矩阵计算优化152

9.3.2 MLA、GQA以及MQA差异详解156

9.4 本章小结157

第 10 章 DeepSeek核心技术3:MoE模型158

10.1 MoE架构158

10.1.1 MoE模型的基本结构159

10.1.2 MoE模型中的“专家”与“调控”代码实现160

10.1.3 使用MoE模型还是经典的前馈层163

10.2 基于MoE模型的情感分类实战164

10.2.1 基于MoE模型的评论情感分类实战164

10.2.2 MoE模型中负载平衡的实现167

10.3 加载MoE架构的注意力模型169

10.3.1 注意力机制中的前馈层不足170

10.3.2 MoE可作为前馈层的替代173

10.3.3 结合MoE的注意力机制175

10.4 基于MoE与自注意力的图像分类175

10.4.1 基于注意力机制的ViT模型176

10.4.2 Patch Embedding与Position Embedding177

10.4.3 可视化的Vision-MoE的详解179

10.4.4 V-MoE模型的实现182

10.4.6 使用已有的库实现MoE184

10.5 本章小结185

第 11 章 DeepSeek核心技术4:MTP与多组件优化186

11.1 深度学习中的精度计算详解与实战186

11.1.1 深度学习中的精度详解187

11.1.2 不同精度的相互转换与混合精度188

11.1.3 PyTorch中混合精度详解191

11.1.4 使用混合精度完成模型训练与预测192

11.2 生成模型的多词元预测196

11.2.1 MTP的经典架构设计与损失函数196

11.2.2 DeepSeek中MTP架构198

11.2.3 多词元预测模型的完整实现199

11.2.4 多词元预测模型的训练与推理200

11.3 自回归模型中的单分类与多分类激活函数203

11.3.1 生成模型中的单分类激活函数203

11.3.2 生成模型中的多分类激活函数207

11.4 DeepSeek中的激活函数SwiGLU209

11.4.1 SwiGLU激活函数详解209

11.4.2 SwiGLU的PyTorch实现210

11.4.3 结合经典缩放的SwiGLU211

11.5 本章小结212

第 12 章 大模型微调技术与应用213

12.1 什么是模型微调213

12.1.1 大模型微调的作用213

12.1.2 大模型微调技术有哪些214

12.1.3 参数高效微调详解215

12.2 大模型微调方法LoRA详解216

12.2.1 LoRA微调的优势216

12.2.2 LoRA基本公式推导217

12.2.3 PyTorch获取内部参数的方法218

12.3 多模态DeepSeek大模型本地化部署与微调实战219

12.3.1 多模态DeepSeek大模型的本地化部署219

12.3.2 微调的目的:让生成的结果更聚焦于任务目标221

12.3.3 适配DeepSeek微调的辅助库PEFT详解224

12.3.4 基于本地化部署的DeepSeek微调实战226

12.4 本章小结232

第 13 章 大模型蒸馏技术与应用233

13.1 什么是模型蒸馏233

13.1.1 模型蒸馏的核心原理与应用价值234

13.1.2 在线与离线大模型蒸馏的实施方法234

13.2 基于在线DeepSeek大模型的离线蒸馏235

13.2.1 模型蒸馏的前置准备235

13.2.2 通过在线DeekSeek API进行蒸馏处理236

13.3 基于物理信息神经网络的在线蒸馏238

13.3.1 在线蒸馏的损失函数与经典微分方程的求解方法239

13.3.2 基于PINN蒸馏求解微分方程的实战240

13.4 本章小结245

第 14 章 后训练算法GRPO详解与实战246

14.1 基于GRPO的平衡车自动控制实战247

14.1.1 CartPole强化学习环境设置247

14.1.2 基于GRPO的CartPole模型训练248

14.1.3 基于GRPO后的CartPole模型演示252

14.2 GRPO算法详解255

14.2.1 从PPO对比GRPO256

14.2.2 GRPO核心原理与案例演示258

14.2.3 GRPO原理的补充问答259

14.2.4 平衡车中的GRPO控制详解261

14.3 本章小结263

第 15 章 基于GRPO后训练的智能医疗问诊实战265

15.1 模型的后训练与逻辑能力265

15.1.1 大模型的后训练概念与核心目标266

15.1.2 结果奖励与过程奖励:奖励建模详解267

15.2 带推理的智能医疗问诊实战269

15.2.1 推理医疗数据集的准备与处理269

15.2.2 奖励函数的完整实现271

15.2.3 基于GRPO后训练的智能医疗问诊实战273

15.2.4 智能医疗问诊模型的推理展示276

15.3 本章小结277

16.1.3 用于复杂任务分配、解决与汇总的A2A架构281

16.2.3 使用LoRA微调基座模型285

16.3.2 更高精度的RAG详解与使用示例295

16.3.3 基于BM25算法的RAG实战296

16.3.4 基于Conan Embedding向量排序的RAG实战300

16.4 搭建基于DeepSeek的调度Agent308

16.5.3 A2A与MCP的结合与展望321

16.6 本章小结323

编辑推荐

(3)本书还可以结合《DeepSeek大模型高性能核心技术与多模态融合开发》一书中的案例,对DeepSeek应用与多模态开发进行深入研究。

(4)本书围绕DeepSeek大模型应用开发展开,深度融合技术创新与工程实践,内容覆盖大模型应用开发(在线调用、提示词、推理、Agent、工具调用、MCP、微调、蒸馏、后训练、RAG)常用技术栈及其案例。

(5)本书原理与实战案例相融合,注重培养读者的大模型原生应用与AI Agent智能体开发能力,并构建从理论到落地的完整知识体系。

(6)本书通过代码级详解与量化实验对比,将KV Cache、MLA注意力、MoE专家模型、MTP输出等前沿技术转化为可复现的工程能力,帮助读者深入理解大模型的技术逻辑。

(7)配套示例源码、数据文件、PPT课件、配图PDF文件、读者微信交流群。

本书特色

本文摘自《DeepSeek原生应用与智能体开发实践》,获出版社和作者授权发布。